写在前面:

实际测试OpenAI新发布的「草莓」后,发现问题很多

。

在本篇中,我将分几个章节,来进行全面解读,包括:

长话短说

中国时间9月13日凌晨,OpenAI发布了o1系列模型,包括o1-preview和o1-mini,官方称其为「草莓」。《》

从OpenAI公布的数据来看,o1在STEM(理工科)领域进行了特别优化,在回答之前会进行思考

。在物理、生物和化学问题(GPQA)的基准测试中超越了人类博士水平的准确性。

Plus和Team的用户可在ChatGPT中访问

,o1-preview限制在了30条/周,o1-mini限制在了50条/周

T5级别的开发者可以访问其API

,每分钟最多20并发,且价格昂贵。

目前,这个模型还是个半成品,并没有工程化完整

:在ChatGPT里不支持联网、画图等功能;在API里不支持system、tool等字段和jsonmode、结构化输出等方法。

同时,这个模型有坑-你可能会被百倍计费

:从pricingtable上看,o1的价格是4o的6倍,但这是有迷惑性的!o1计费并不按最终输出,其中间思考过程所消耗的token,并被视作outputtokens,这意味着100tokens的内容输出,可能会被按10000tokens计费。

这个模型说是有32k/64k的最大输出,但真实输出远没有这么多

从实际测试的角度,发现o1与其说是一个模型,不如说是基于gpt-4o的agent,并且做的并不好

进行structured输出时,400报错

效果与特性

首先,o1模型是OpenAI官方认定的「草莓🍓」

其次,「草莓」实测:可能只是工程,且有扣费陷阱!奥特曼对此很满意

在其测试结果中,o1在绝大多数重推理任务中显著优于GPT-4o,相关评估如下:

结果上看,显著优于gpt-4o

在MMLU的多绝大多数子类别中,优于gpt-4o

同时,根据官方报告,在许多需要推理的测试中,o1的表现已经达到了人类专家的水平。因为最近一些模型在MATH和GSM8K测试中表现得非常出色,这些测试已经不足以有效地区分它们的优劣。为了更严谨地评估模型的数学能力,选择了AIME(美国数学邀请赛),这是一项专门为美国顶尖高中数学学生设立的挑战性考试。

在2024年的AIME考试中,GPT-4o的平均成绩只有12%(1.8/15),而o1的平均得分却达到了74%(11.1/15)。在只用一个答案的情况下,o1在64个样本上的平均正确率达到了83%(12.5/15)。当使用学习算法对1000个样本进行优化排序后,o1的得分进一步提高到93%(13.9/15)。这个成绩相当于进入全国前500名学生的水平,甚至超过了美国数学奥林匹克的入围标准。

价格与限制

目前o1系列模型可通过ChatGPT网页版,或者是API进行访问:

o1-mini:

对于ChatGPT网页版,目前仅Plus和Team用户目前已经可以访问了。对于Enterprise以及Edu的用户,还需要再等一周:

对于API用户,如果你的等级在Tire5(支付金额>1000美金),目前已经可以通过接口进行调用:

需要注意

经测试,o1模型不支持以下内容,并报错:

更需要注意

对于api,文档说o1可以输出64k,但实测远非如此

“谨防电信诈骗”

实现原理

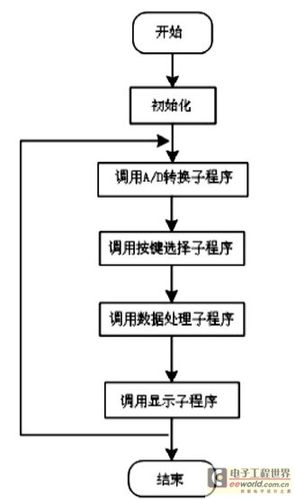

简而言之,o1系列模型,在回答的过程中,本身经历了多次对话,并根据对对话的评估,进行后续生成。

他会先思考,然后总结输出

思考可能不止一步,最长思考步骤为128k,具体步骤如下:

需要注意:在api调用的过程中,并不会返回中间的思考,比如相同的问题「安徽牛肉板面,为什么是石家庄特产?」,api侧的返回如下:

我把id等信息给***了

这个时候,你会发现一个严重问题:此处产生了896tokens作为推理。

换个例子,当问题是很简短的「你好」时,其返回如下:

输出471tokens,其中448tokens为推理,23tokens为真实输出

同样的问题,问4o:

输出为9tokens

要知道,o1模型的价格,时4o-0806的6倍。再加上对推理的消耗(额外n倍),以及这个模型里,token计算可能比4o要多(猜测),api开支可能会炸!

以「你好」为例,4o-0806的费用为($10*9 $2.5*8)*10^(-6)=110*10^(-6)美金;而o1模型中,费用则为($60*471 $15*10)*10^(-6)=28410*10^(-6)美金。在这个案例中,完成相同的任务,o1比4o贵了足足258倍!!!

对于非极端问题,且在prompt较短的情况下,比如「安徽牛肉板面,为什么是石家庄特产?」,4o-0806的开销为2192.5*10^(-6)美金,而o1的开销为86835*10^(-6)美金。在这个案例中,完成相同的任务,o1比4o贵了40倍!!!

有理由认为:在正常使用中,o1的开销,会比4o贵百倍!

一些判断

首先,我保持一个观点:这次的「草莓」,与其说是模型优化,不如说是工程优化

从训练数据,以及训练时间来看,o1-preview,o1-mini,4o,4o-mini的训练数据,都是截止到2023年10月(而更早的gpt-4-0125和gpt-4-turbo则是截止到2023年12月)

在抛去CoT行为后,可以发现o1和4o的行为/语言风格高度相似,甚至可以猜测:这次的「草莓」o1有可能是gpt-4o在进行一些微调/对齐后的agent

当我询问「我的猫为什么不会汪汪叫」的时候,出现了典型的「意图识别」

同时,这个Agent做得并不好,甚至不能算是及格。当我用o1-mini进行「完整输出千字文」的时候,无论是语言识别、意图识别还是指令遵循,都非常的不尽如人意:

o1-mini

即便是换用所谓更强的o1-preview,结果也不尽如人意(选中文字是错的),并且输出也不全。

o1-preview

综上

这个版本的草莓,远低于预期,甚至不如民间的工程化

作为AI从业者,有种难以言表的伤感:我们会喜欢看OpenAI的乐子,但绝对不希望看到OpenAI塌...

如果你看到了这...建议返回上一级,看下本次推送的次条:宝玉老师对「汉语新解」的原理解读,相信会更有收获