机器之心报道

机器之心编辑部

注意力是Transformer架构的关键部分,负责将每个序列元素转换为值的加权和。将查询与所有键进行点积,然后通过softmax函数归一化,会得到每个键对应的注意力权重。

尽管SoftmaxAttn中的softmax具有广泛的用途和有效性,但它并非没有局限性。例如,softmax函数有时会导致注意力集中在少数几个特征,而忽略了其他信息。

近来,一些研究探索了Transformer中softmax注意力的替代方案,注意力一样强,苹果开始重新审视注意力机制例如ReLU和sigmoid激活函数。最近,来自苹果的研究者重新审视了sigmoid注意力并进行了深入的理论和实验分析。

该研究证明:从理论上讲,与softmax注意力相比,具有sigmoid注意力的Transformer是通用函数逼近器,并且受益于改进的正则化

。

该研究还提出了一种硬件感知且内存高效的sigmoid注意力实现——FLASHSIGMOID。FLASHSIGMOID在H100GPU上的推理内核速度比FLASHATTENTION2提高了17%。

跨语言、视觉和语音的实验表明,合理归一化的sigmoid注意力与softmax注意力在广泛的领域和规模上性能相当,而之前的sigmoid注意力尝试无法实现这一点。

此外,该研究还用sigmoid内核扩展了FLASHATTENTION2,将内核推理挂钟时间减少了17%,将现实世界推理时间减少了8%。

论文作者JasonRamapuram表示:如果想让注意力快18%左右,你不妨试试Sigmoid注意力机制。他们用Sigmoid和基于序列长度的常量标量偏置取代了注意力机制中的传统softmax。

igmoid注意力理论基础

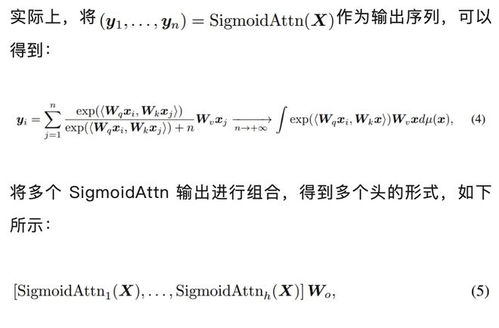

该研究对SigmoidAttn进行了分析,分析的目的主要有两个:(1)证明当SigmoidAttn取代SoftmaxAttn时,Transformer架构仍然是一个通用函数逼近器;(2)通过计算SigmoidAttn的Lipschitz常数来恢复其规律性。

具有Sigmoid注意力的Transformer是通用逼近器吗?

经典Transformer可以将连续的序列到序列函数近似到任意精度,这一特性称为通用近似特性(UAP,UniversalApproximationProperty)。UAP非常受欢迎,因为它证明了架构的通用性和表示能力。由于SigmoidAttn修改了Transformer架构,因此从理论上保证这种修改不会影响表示能力并保留UAP的性能至关重要。该研究通过以下定理提供此保证。

结果表明,即使使用SigmoidAttn,一系列transformer块也可以实现上下文映射。

Sigmoid注意力的正则性

与神经网络中的任何层一样,SigmoidAttn的正则性值得研究,因为它可以深入了解相应网络的鲁棒性及其优化的难易程度。

SigmoidAttn正则性定理为:

结果证明,SigmoidAttn的局部Lipschitz常数远低于SoftmaxAttn的最差局部Lipschitz常数。

FLASHSIGMOID:硬件感知实现

现代架构上的注意力计算往往会受到内存访问IO的限制。FLASHATTENTION和FLASHATTENTION2通过优化GPU内存层次结构利用率来加速注意力计算。得益于这些方法提供的速度提升,该研究开发了SigmoidAttn的硬件感知实现——FLASHSIGMOID,采用了三个核心思路:

实验

为了实验验证SigmoidAttn,该研究在多个领域进行了评估:使用视觉transformer进行监督图像分类、使用SimCLR进行自监督图像表示学习、BYOL(BootstrapYourOwnLatent)和掩码自动编码器(MAE)以及自动语音识别(ASR)和自回归语言建模(LM)。

该研究还在TED-LIUMv3上验证了ASR的序列长度泛化,在所有这些领域和算法中,该研究证明SigmoidAttn的性能与SoftmaxAttn相当(图2和21),同时提供训练和推理加速。

该研究得出以下观察结果:

SigmoidAttn对于没有偏置的视觉任务是有效的(MAE除外),但依赖于LayerScale以无超参数的方式匹配基线SoftmaxAttn(图9-a)的性能。除非另有说明,否则为SoftmaxAttn呈现的所有结果也公平地添加了LayerScale。

LM和ASR对初始范数较为敏感。需要通过(a)相对位置嵌入进行调整;(b)适当初始化b以实现相同效果——允许使用任何位置嵌入。

感兴趣的读者可以阅读论文原文,了解更多研究内容。