比尔·盖茨称不要太担心耗电;推出全新模型|钛媒体

今天,通用人工智能(AGI)领域又公布了一系列重磅消息,比尔·盖茨称不要太担心耗电;推出全新模型|钛媒体包括比尔·盖茨披露AI用电问题,OpenAI推出新模型CriticGPT,全球首家AI生活实验室在北京海淀落地等。

下面,钛媒体AGI编辑简单梳理了AI领域的重要消息。

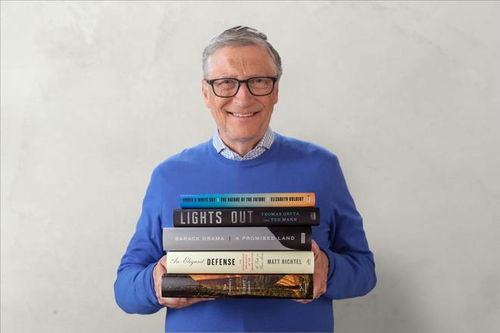

比尔·盖茨:我们不要过分担心人工智能的用电问题

钛媒体App6月28日消息,今晨伦敦举行的突破能源峰会(BreakthroughEnergySummit)上,微软联合创始人比尔·盖茨(BillGates)为AI系统导致的能源使用快速增长进行了辩护,认为该技术最终将抵消其大量电力消耗。

比尔·盖茨敦促环保人士和政府“不要过分”关注运行新的生成式人工智能系统所需的大量电力,微软等大型科技公司正竞相投资数百亿美元建设庞大的新数据中心。

盖茨称,数据中心将推动全球用电量增长2%至6%。“问题是,AI会加速超过6%的减排吗?答案是:当然。”而他表示,科技公司在寻求新的电力来源时,将为清洁能源支付“绿色溢价”,即更高的价格,这有助于推动其开发和部署。

“科技公司愿意支付溢价,帮助提升绿色能源产能。”比尔·盖茨表示。

然而,美国能源部4月份的一份报告称,AI“有望在不久的将来成为美国数据中心相关负荷增长的最大驱动力”。

美国能源部表示,尽管亚马逊和微软等公司已与风能和太阳能发电企业签署了长期购电协议,但这些协议“通常无法使电力需求与当地资源相匹配”。这意味着协议“不能保证所有与电力相关的温室气体排放都被抵消”。

因此,很显然,比尔·盖茨的看法与美国能源部相左。

实际上,今年5月,微软承认其温室气体排放量自2020年以来增加了近三分之一,这在很大程度上是由于数据中心的建设。

盖茨于2020年离开微软董事会,但仍是首席执行官萨蒂亚•纳德拉(SatyaNadella)的顾问,所谓的突破能源集团,是由比尔·盖茨创立,投资者包括杰夫·贝佐斯、孙正义和马云。该集团已经投资了100多家开发可持续能源和其他技术以减少温室气体排放的公司。

目前,包括微软、亚马逊和谷歌在内的大型科技集团已提出计划,斥资数百亿美元在世界各国建设运行AI系统所需的计算基础设施。但是,电力供应方面的限制已经给寻求建立新技术的公司带来了挑战。

今年5月,美国电力研究所(ElectricPowerResearchInstitute)表示,到2030年,数据中心可能消耗至多9%的美国发电量,是目前用电量的两倍多。

尽管比尔·盖茨认为,科技公司正在推动绿色能源的推广,但他表示,他最大的担忧之一是“获得足够的电力”,以满足不断增长的需求,同时还要清洁水泥和钢铁等庞大行业。

“我们转型所需的绿色电力数量不会以我们需要的速度出现。”比尔·盖茨称,到2050年实现净零排放的全球目标很可能无法实现,他认为“再过10年或15年可能更现实”。

让GPT-4帮人类训练GPT-4,OpenAI推出新模型CriticGPT

美东时间6月27日周四,OpenAI公司宣布,其研究人员训练了一个基于GPT-4的模型,称为CriticGPT,用于捕捉ChatGPT代码输出中的错误。

简单来说就是,CriticGPT让人能用GPT-4查找GPT-4的错误。它可以写出使用者对ChatGPT响应结果的批评评论,从而帮助人类训练者在RLHF期间发现错误。CriticGPT用于给代码挑Bug时能找到75%以上,而相比之下人类只能找到不到25%。

OpenAI发现,如果通过CriticGPT获得帮助审查ChatGPT编写的代码,人类训练师的审查效果比没有获得帮助的人强60%。OpenAI称,正着手将类似CriticGPT的模型集成到旗下RLHF(基于人类反馈的强化学习)标记管道中,为自己的训练师提供明确的AI帮助。

OpenAI称,因为没有更好的工具,所以人们目前难以评估高级的AI系统的表现。而CriticGPT意味着,OpenAI向能够评估高级AI系统输出的目标迈进了一步。

OpenAI举了一个例子。如下图所示,对ChatGPT提出一个用Python编写指定函数的任务,对于ChatGPT根据要求提供的代码,CriticGPT点评了其中一条指令,提议换成效果更好的。

另外,OpenAI还披露了CriticGPT的主要功能、工作原理、优势和局限性。

CriticGPT的主要功能

代码审核:自动审查由其他AI模型生成的代码,识别潜在的逻辑错误和安全漏洞。

错误识别:检测代码中的语法错误、运行时错误以及可能的编程失误。

安全漏洞分析:专门分析代码,找出可能导致安全问题的漏洞,如路径遍历、注入攻击等。

反馈生成:为开发人员提供具体的错误反馈和改进建议,帮助他们理解并修复问题。

性能评估:评估AI生成的代码在性能上是否达到预期标准。

辅助学习:通过提供错误示例和正确做法,辅助开发人员和AI训练师学习和提高。

CriticGPT的工作原理

错误注入:首先,通过一种称为”篡改”的方法,人类评估员故意在AI生成的代码中插入细微的错误,然后记录下这些错误的详细描述。这个过程类似于代码审查中发现错误并记录错误的方式。

训练数据生成:这些被篡改的代码样本和相应的错误描述被用来训练CriticGPT,使其能够识别和指出各种潜在问题。

评论生成:CriticGPT接收一个问题和相应的回答作为输入,然后生成一个评论,指出回答中的具体错误。评论的结构通常包含多个部分,每个部分都针对原始回答中的特定引用进行评论。

策略优化:使用近端策略优化(PPO)算法来优化CriticGPT的行为策略,允许模型在保持策略更新幅度较小的同时,有效地学习如何改进其输出。

推理采样策略:引入了一种名为”强制采样波束搜索”(FSBS)的技术,通过在生成评论时强制模型产生特定的高亮部分,然后根据奖励模型的评分选择最佳评论。这种方法允许模型在生成更长、更全面的评论时,减少虚假问题的产生。

性能评估:CriticGPT的输出会被评估,以确定其在检测代码错误方面的表现,以及与人类评估员相比的优势。

CriticGPT的优点

提高准确性:CriticGPT通过增强RLHF,显著提升了AI模型输出的准确性,尤其在代码审查方面,能找出许多人类难以发现的问题。

减少错误:它能够帮助减少在代码中的错误,特别是那些由于模型复杂度增加而变得更加隐蔽的错误。

提升效率:CriticGPT可以自动化地审查代码,减少了人工审查所需的时间和工作量。

增强安全性:通过识别代码中的安全漏洞,CriticGPT有助于提升软件产品的安全性。

辅助人类评估员:CriticGPT可以作为人类评估员的辅助工具,提高他们审查代码的效率和质量。

自我学习和优化:CriticGPT使用PPO算法进行策略优化,能够不断学习和改进其错误检测的能力。

减少幻觉:CriticGPT有助于减少在评估过程中产生的幻觉或虚假错误,提高了评估的可靠性。

全面性:通过FSBS技术,CriticGPT能够生成更全面、更详细的评论,同时避免了无关紧要的问题或错误。

提升训练数据质量:CriticGPT的使用有助于生成更高质量的训练数据,进一步优化AI模型。

适应性强:CriticGPT的设计使其能够适应不同的AI输出和任务,具有较好的通用性。

CriticGPT的局限

复杂性限制:CriticGPT在处理极复杂的任务时可能会面临挑战,尤其是当错误分布在代码的多个部分时。

短答案训练:该模型主要针对较短的代码片段进行训练,可能在处理更长、更复杂的任务时效果不佳。

幻觉问题:尽管CriticGPT减少了幻觉错误的产生,但仍然存在可能输出不正确内容误导人类的风险。

单一错误焦点:当前CriticGPT主要关注单点错误,对于跨多个代码段的错误可能识别不够。

应用范围:CriticGPT主要针对代码审查,对于其他类型的AI输出(如文本、图像等)可能需要进一步的调整和优化。

依赖训练数据:CriticGPT的性能在很大程度上依赖于训练数据的质量和多样性,如果训练数据存在偏差,可能影响模型的准确性。

谷歌公布270亿参数的最强开源模型Gemma2,吊打Llama3

北京时间6月28日凌晨,谷歌在I/OConnect大会上公布其新一代最强开源模型——Gemma2。

Gemma2有90亿(9B)和270亿(27B)两种参数规模版本。

其中,27B模型训练了13Ttokens,9B是8Ttokens,都拥有8192上下文窗口,可在GoogleAIStudio中使用。26亿参数(2.6B)模型将很快发布,小到可以在手机本地运行。

在盲测大语言模型竞技场LMSYSChatbotArena中,270亿参数的Gemma2指令微调模型击败了拥有700亿参数的Llama3,并超过Nemotron4340B、Claude3Sonnet、CommandR 、Qwen72B等模型,在所有开源权重的模型中位列第一;9B模型则是当前15B以下参数的模型中成绩最好的。

谷歌透露,早前推出轻量级先进开源模型Gemma2B、7B版本下载量超过1000万次。而Gemma2涵盖从20亿到270亿参数,比第一代性能高出2倍以上,推理效率也更高,可以在单个英伟达A100/H100TensorCoreGPU或TPU主机上以全精度高效运行推理,大大降低了部署成本,并且显著改进安全性。这是该系列模型迈出的一大步。

智谱称国产大模型GLM-4-9B性能超过了谷歌Gemma

针对今晨谷歌发布的Gemma-2开源模型,6月28日中午,国内大模型独角兽智谱AI向钛媒体App展示一份数据称,提供的各项评测对比中,近1个月前发布开源的国产大模型GLM-4-9B似乎更具有优势。

据悉,GLM-4-9B是智谱AI推出的最新一代预训练模型GLM-4系列中的开源版本。在语义、数学、推理、代码和知识等多方面的数据集测评中,GLM-4-9B及其人类偏好对齐的版本GLM-4-9B-Chat均表现出较高的性能。GLM-4-9B升级的前身是2023年智谱开源的3代的6B模型,HuggingFace上获得了超过1700万次的下载。

斯坦福AI文档搜索公司Hebbia完成近1亿美元B轮融资,估值达8亿美金

据TechCrunch报道,三位知情人士透露,研发生成式AI搜索大型文档工具的初创公司Hebbia近日已完成由AndreessenHorowitz(a16z)领投的近1亿美元B轮融资。

报道称,本轮融资对该公司的估值在7亿至8亿美元之间。据Hebbia在5月份提交给美国证券交易委员会的文件中披露,该公司当时已筹集到9300万美元,而预期的融资额为1亿美元,但我们从两位知情人士那里了解到,本轮融资接近1亿美元,并且已经结束。

Hebbia和A16z没有回应置评请求。

据悉,Hebbia成立于2020年,创始人是GeorgeSivulka,他在斯坦福大学攻读电气工程博士学位期间创办了这家公司。

Sivulka的灵感来自他在金融行业工作的朋友告诉他,漫长的工作周中有一部分时间是花在搜索SEC文件和其他密集文件中的信息上。Sivulka认为。AI可以帮助他们节省办公室时间,让他们有更多时间休息和睡眠。

该公司表示,Hebbia的AI可以同时查看数十亿份文件,包括PDF、PowerPoint、电子表格和成绩单,并返回具体答案。

这家初创公司主要向金融服务公司销售产品,包括对冲基金和投资银行。但其产品也可供律师事务所和其他专业领域使用。

最新一轮融资使Hebbia的总资本超过1.2亿美元。该公司于2022年9月完成了3000万美元的A轮融资,由IndexVentures领投,RadicalVentures参投。

全球首家AI生活实验室在北京海淀落地,将向公众免费开放

6月28日消息,钛媒体App获悉,全球首家人工智能(AI)生活实验室将于6月30日-7月1日在海淀举办开幕仪式,将向公众免费开放,供广大市民前来体验各式各样的AI产品。

据悉,该生活实验室由海国投(北京市海淀区国有资产投资经营有限公司)旗下北京海新睿人工智能科技有限公司打造,旨在推动AI技术与民生融合,展示当下前沿的AI产品,供社区居民、创业团队、政府人员、投资机构、前沿产业从业者等多元背景的来访者可以在其中交流、碰撞、合作,共同推动AI技术的发展和应用落地。

海新睿总经理赵元章早前表示,尽管大模型技术不断涌现,但如何将这些技术转化为实际生产力,改善人民生活,并为企业带来商业价值,仍是一个亟待解决的问题。海新睿的解决方案即是为AI企业提供“产品经理”角色,通过“生活实验室”搭建连接B端与C端的桥梁,提供使用场景和丰富真实的用户数据,反哺产品的开发与打磨,使其更符合用户和市场的需要,有更大的几率成为爆款,从而加速技术应用落地。

据了解,生活实验室基于“社会设计”的理念,为了探索AI技术与生活融合的可能,模拟卧室、游乐场、会客厅、社区等真实场景,设计了不同的计划。诸如“橙色温度计划”被打造成孩子卧室的模样,希望守护孩子们的情绪健康,及时排查干预心理问题;“超越百岁计划”是一个老人的小公寓,“第二人生计划”则是一个微型的“社区”,分别探索如何减少老人病痛、培养老人兴趣爱好,帮助老人延缓衰老、缓解晚年的孤独感,丰富生活品质。

海新睿方面透露,未来三年,海新睿计划培育孵化10-20家独角兽级AI垂直应用企业,专注于老龄和青少年领域,形成具有全球影响力的产品体系,联合上下游企业一同培育AI产业生态,推动AI技术惠及更多人群。

字节跳动发布豆包MarsCo智能开发工具

6月27日下午,字节跳动发布了基于豆包大模型打造的智能开发工具豆包MarsCode,面向国内开发者免费开放。豆包MarsCode包括编程助手和CloudIDE两种产品形态,可在需求开发、修复Bug、开源项目学习三个实际场景中实现项目问答、代码补全、单测生成、BugFix等功能,帮助开发者提升效率。

目前,MarsCode编程助手支持Python、Go、JS、TS、C 、Java、Kotlin、C、Rust等超过100种主流编程语言,兼容VSCode和JetBrains代码编辑器,支持代码补全、单测生成、代码解释、代码推荐Pro(Beta)、生成注释、错误修复、AI问答等功能。

(本文首发于钛媒体App,作者|林志佳,编辑|胡润峰)