IT之家7月31日消息,苹果公司最新发布论文[PDF],分享了关于AppleIntelligence模型的相关细节,部分性能已经超过OpenAI的GPT-4。

模型简介苹果在论文中介绍了AppleFoundationModel(下文简称AFM)模型,共有以下两款:

AFM-on-device:本地运行,30亿参数,文本总结等方面超过,苹果披露模型细节可以在iPhone、iPad等设备上高效运行;

AFM-server:苹果尚未公布参数等细节。

训练数据来源苹果表示训练数据集包括从出版商处获得授权的数据、经过策划的公开或开源数据集以及我们的网络爬虫Applebot抓取的公开信息组成。

苹果强调注重保护用户隐私,数据混合物中不包括苹果用户的私人数据。

据《纽约时报》报道,苹果公司在2023年底与NBC、CondéNast和IAC等多家出版商达成了价值至少5000万美元的多年期协议,在出版商的新闻档案中训练模型。

苹果的AFM模型还在GitHub上托管的开源代码上进行了训练,特别是Swift、Python、C、Objective-C、C 、JavaScript、Java和Go代码。

论文称,为了提高AFM模型的数学技能,苹果公司特别在训练集中加入了来自网页、数学论坛、博客、教程和研讨会的数学问题和答案。

苹果利用了高质量、可公开获得的数据集(论文中未提及名称),这些数据集“拥有允许用于训练......模型的许可证”,并经过过滤以去除敏感信息。

AFM模型的训练数据集约有6.3万亿个token(token是小块数据,通常更容易被生成式人工智能模型吸收)。相比之下,这还不到Meta用来训练其旗舰文本生成模型Llama3.1405B的token数量(15万亿)的一半。

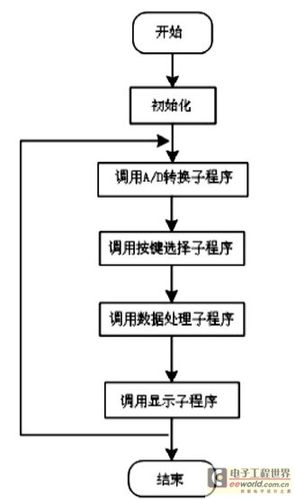

训练硬件根据论文描述,苹果公司使用8192片TPUv4芯片训练AFM-server模型;2048片TPUv5p芯片训练AFM-on-device模型。

每个v5ppod由8960个芯片组成,每秒的浮点运算(FLOPS)和内存分别是TPUv4的两倍和三倍,训练模型的速度快了近三倍。

模型性能根据论文描述,苹果自研大模型在指令遵循、文本总结方面测试超GPT-4。

苹果公司的数据显示,AFM-server有害输出违规率为6.3%,明显低于GPT-4的28.8%。同样,在设备上,AFM7.5%的违规率低于Llama-3-8B(由Facebook母公司Meta训练)21.8%的得分。

在电子邮件、信息和通知汇总方面,设备上的AFM的满意度分别为71.3%、63%和74.9%。研究论文还指出,这三个模型分别领先于Llama、Gemma和Phi-3模型。IT之家附上相关性能结果如下: